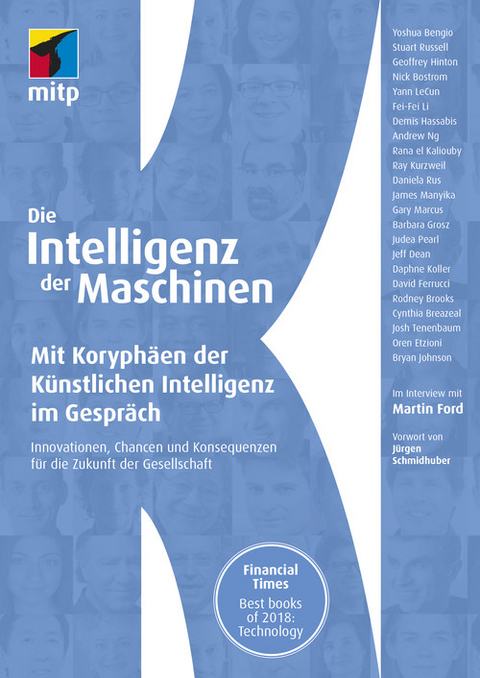

Die Intelligenz der Maschinen (eBook)

556 Seiten

MITP Verlags GmbH & Co. KG

978-3-7475-0011-8 (ISBN)

- Ausgewählt von der Financial Times als eines der Best Books of the Year 2018 (Technology)

- Die international bekanntesten KI-Experten im Interview: Geoffrey Hinton, Yoshua Bengio, Yann LeCun und viele mehr

- Breit gefächertes Themenspektrum von technischen Aspekten über die Zukunft der KI bis hin zu ihren Auswirkungen auf Wirtschaft und Gesellschaft

Wohin wird uns die Künstliche Intelligenz in Zukunft führen? Welchen Einfluss wird sie auf den Arbeitsmarkt, die Wirtschaft und die Gesellschaft nehmen? Welche Chancen und Probleme entstehen, wenn die Entwicklung der KI immer weiter fortschreitet? In diesem Buch führt Martin Ford über zwanzig Interviews mit bedeutenden Köpfen der KI aus dem englischsprachigen Raum und lässt dabei Forscher, Unternehmer und Kritiker zu Wort kommen.

Gemeinsam mit seinen Gesprächspartnern beleuchtet er den aktuellen Stand der Technik, künftige Entwicklungsmöglichkeiten der KI sowie deren Auswirkungen auf unser soziales und wirtschaftliches Leben.

Themen der Interviews sind zum Beispiel Erkenntnisse zur emotionalen Intelligenz der KI (Rana el Kaliouby), die Notwendigkeit für mehr Diversität in der KI-Forschung (Fei-Fei Li) sowie Analysen der Auswirkungen von KI auf Unternehmen und Wirtschaft (James Manyika). Sie erhalten auch Einblick in verschiedene KI-Methoden, u.a. von Preisträgern des Turing Awards, Forschern am MIT und Entwicklern bei bekannten Unternehmen wie Google und Facebook.

Werden Roboter in Zukunft die Pflege älterer und kranker Menschen übernehmen und Computerchips in unseren Gehirnen unsere menschlichen Fähigkeiten optimieren? Oder müssen wir uns doch eher vor amoklaufenden Killerrobotern oder einer totalen Machtübernahme durch Maschinen fürchten?

Mit einem Vorwort von KI-Pionier Jürgen Schmidhuber, dessen Team an der TU München und am Schweizer Forschungsinstitut IDSIA die tiefen neuronalen Netze entwickelt hat, die zum Kern der KI auf Milliarden von Smartphones wurden. Er erläutert die weltweiten historischen Entwicklungen in der KI-Forschung und stellt ergänzend die richtungsweisenden Pioniere vor, die nicht aus dem englischsprachigen Raum kommen.

Martin Ford spricht mit:Yoshua Bengio (University of Montreal), Stuart Russell (University of California, Berkeley), Geoffrey Hinton (University of Toronto und Google), Nick Bostrom (University of Oxford), Yann LeCun (Facebook), Fei-Fei Li (Stanford University und Google), Demis Hassabis (DeepMind), Andrew Ng (AI Fund), Rana el Kaliouby (Affectiva), Ray Kurzweil (Google), Daniela Rus (MIT), James Manyika (McKinsey Global Institute), Gary Marcus (New York University), Barbara Grosz (Harvard University), Judea Pearl (University of California, LA), Jeff Dean (Google), Daphne Koller (Stanford University), David Ferrucci (Elemental Cognition), Rodney Brooks (Rethink Robotics), Cynthia Breazeal (MIT), Josh Tenenbaum (MIT), Oren Etzioni (Allen Institute for AI), Bryan Johnson (Kernel)

Stimmen zum Buch:»In seinem neuen Buch gibt uns Martin Ford die großartige Möglichkeit, von einigen der prominentesten Vordenker etwas über die neuen Bereiche der Wissenschaft zu erfahren, die unsere Zukunft bestimmen werden.«

- AL GORE, ehemaliger Vizepräsident der USA

»Der beste Weg, die Herausforderungen und Folgen einer ?Artificial General Intelligence? zu verstehen, ist ein Blick in die Köpfe der Experten, die das Feld prägen. ?Die Intelligenz der Maschinen? gibt Ihnen diese Möglichkeit.«

- SAM ALTMAN, Präsident von Y Combinator und Co-Chairman von OpenAI

Martin Ford ist ein bekannter Futurist, Gründer einer Softwareentwicklungsfirma und Autor des Bestsellers Rise of the Robots (deutscher Titel: Aufstieg der Roboter). Er beschäftigt sich insbesondere mit der Automatisierung durch Robotik und Künstliche Intelligenz und ihren Auswirkungen auf die Zukunft.

Martin Ford ist ein bekannter Futurist, Gründer einer Softwareentwicklungsfirma und Autor des Bestsellers Rise of the Robots (deutscher Titel: Aufstieg der Roboter). Er beschäftigt sich insbesondere mit der Automatisierung durch Robotik und Künstliche Intelligenz und ihren Auswirkungen auf die Zukunft.

Vorwort zur deutschen Ausgabe

von Jürgen Schmidhuber

Nach mehr als einem Jahrhundert Forschung zur Künstlichen Intelligenz (KI) hat das Gebiet jüngst enorm an Bedeutung und Beliebtheit gewonnen. Insbesondere die Mustererkennung und das maschinelle Lernen wurden durch das sogenannte Tiefe Lernen oder Deep Learning (DL) revolutioniert. DL ist dabei nur ein neuer Spitzname für tiefe künstliche Neuronale Netze (NN), die aus Erfahrung lernen. Heute wird DL in der Industrie und im Alltag massiv genutzt, z.B. für die Bild- und Spracherkennung auf Ihrem Smartphone oder für die automatische Übersetzung von einer Sprache in eine andere.

Das vorliegende Buch ist eine Sammlung von Interviews mit Forschern, die an Aspekten der KI gearbeitet haben. Allerdings haben alle Befragten ihren Sitz in der Anglosphäre, obwohl DL und die moderne KI an Orten erfunden wurden, wo Englisch keine offizielle Sprache ist. Deshalb werde ich dieses Vorwort nutzen, um einige der im Rest des Buches nicht berücksichtigten Pioniere des Gebiets hervorzuheben.

Lassen Sie uns zunächst einen Schritt zurücktreten und einen Blick auf die KI-Geschichte im weiteren Kontext der Geschichte des automatischen Rechnens werfen.

Europa ist die Wiege der mechanischen Rechner und der KI. Der Antikythera-Mechanismus Altgriechenlands (aus dem ersten Jahrhundert v. Chr.) wurde an Raffinesse erst eineinhalb Jahrtausende später übertroffen durch Henleins miniaturisierte Taschenuhren (Nürnberg, 1505). 1623 konstruierte Schickard in Tübingen den ersten Rechner für Grundrechenarten. Um 1700 entwickelte Leibniz die heute allgemein übliche binäre Computerarithmetik. Mustererkennung durch lineare Regression oder Flaches Lernen begann um 1800 durch Gauß & Legendre. Die ersten programmgesteuerten Maschinen (es waren Webstühle) entstanden ebenfalls zu dieser Zeit in Frankreich durch Jacquard und andere. Bald darauf kamen erste (allerdings unverwirklichte) Ideen für Allzweckrechner auf (Babbage in Großbritannien um 1830). Im vergangenen Jahrhundert beschleunigten sich die Fortschritte dramatisch. Hier ein kleiner Überblick über Glanzlichter der KI seit 1900:

Meines Wissens war der erste Pionier der praktischen KI der Spanier Leonardo Torres y Quevedo, der schon 1914 eine funktionierende Schach-Endspielmaschine schuf. Damals galt Schachspielen noch als intelligente Aktivität.

Der Begründer der KI-Theorie und der theoretischen Informatik im Allgemeinen war der Österreicher Kurt Gödel, der 1931 die erste universelle formale Sprache veröffentlichte (basierend auf den ganzen Zahlen), und damit nicht nur beliebige Rechenprozeduren wie z.B. Theorembeweiser beschreiben konnte, sondern auch selbstbezügliche formale Aussagen aufstellte, die von sich behaupten, dass kein solcher Theorembeweiser sie beweisen kann. So enthüllte er grundlegende Grenzen der Mathematik, der Berechenbarkeit und der KI (1931). Ein Großteil der späteren KI in den 1960er-/70er-Jahren drehte sich in der Tat um Deduktion und das Beweisen von Theoremen im Gödel-Stil durch Expertensysteme. Mehr unter: http://people.idsia.ch/~juergen/goedel.html

1935 veröffentlichte Alonzo Church in den USA eine alternative universelle Sprache namens Lambda-Kalkül (Basis von LISP) und erweiterte damit Gödels Ergebnisse auf Hilberts berühmtes Entscheidungsproblem, welches im Allgemeinen unlösbar ist. Im folgenden Jahr formulierte Alan Turing in Großbritannien dieses Resultat mithilfe eines weiteren universellen Konstruktes, der Turing-Maschine (1936), um. Später schlug er auch einen subjektiven KI-Test vor. Mehr unter: http://people.idsia.ch/~juergen/turing.html

Von 1935-1941 baute Konrad Zuse in Berlin den ersten praktischen, funktionierenden, programmgesteuerten Computer. In den 1940er-Jahren entwickelte er auch die erste höhere Programmiersprache und schrieb das erste allgemeine Schachprogramm (Schachspielen galt damals immer noch als intelligente Aktivität). Mehr unter: http://people.idsia.ch/~juergen/zuse.html

Der Begriff KI wurde 1956 durch John McCarthy auf der Dartmouth Konferenz geprägt. Das Thema an sich wurde jedoch bereits fünf Jahre zuvor auf der berühmten Pariser Konferenz zu Rechenmaschinen und menschlichem Denken behandelt. Dort spielte u.a. der Kybernetik-Pionier Norbert Wiener gegen die bereits erwähnte Schachmaschine von Torres. Die entsprechende 570 Seiten umfassende Veröffentlichung heißt Les Machines à Calculer et la Pensee Humaine: Paris, 8.-13. Januar 1951, Colloques internationaux du Centre National de la Recherche Scientifique; Nr. 37, Paris 1953. Herbert Bruderer bezeichnet die Pariser Konferenz zu Recht als die erste zur KI.

Der erste berühmte Fall von Mustererkennung durch Flaches Lernen trug sich meines Wissens schon vor zwei Jahrhunderten zu: Die Wiederentdeckung des Planetoiden Ceres um 1800 durch Carl Friedrich Gauß, der aus Datenpunkten früherer Beobachtungen mit verschiedenen Tricks die Parameter eines Prädiktors adjustierte, welcher die Trainingsdaten verallgemeinerte, um den neuen Standort von Ceres richtig vorherzusagen. Damals kamen Gauß und der französische Mathematiker Adrien-Marie Legendre auf die noch immer weit verbreitete Methode der kleinsten Quadrate und der Regression zur Mustererkennung. Frank Rosenblatts einschichtiges lernendes neuronales Netz (NN) der 1950er-Jahre (das Perzeptron) war im Wesentlichen eine Variante der alten linearen Regressoren.

Ein wichtiges Teilgebiet der modernen KI, das heute oft als Deep Learning (DL) bezeichnet wird, geht über diese frühen Arbeiten hinaus. Betrachten wir das menschliche Gehirn. Es verfügt über etwa 100 Milliarden Neuronen, jedes mit durchschnittlich 10.000 anderen Neuronen verbunden. Einige sind Eingabeneuronen, die den Rest mit Daten füttern (Gehör, Sicht, Tastsinn, Schmerz, Hunger). Andere sind Ausgabeneuronen, die Muskeln bewegen. Die meisten Neuronen befinden sich dazwischen, wo das Denken stattfindet. Alle lernen, indem sie die Verbindungsstärken ändern, die bestimmen, wie stark Neuronen einander beeinflussen. Dasselbe gilt für unsere tiefen künstlichen NN, die besser lernen als frühere Methoden, Sprache, Handschrift oder Videos zu erkennen, Schmerzen zu minimieren, Lust zu maximieren, Auto zu fahren usw.

Auch DL wurde in Europa geboren, und zwar im Jahre 1965 in der Ukraine, damals Teil der Sowjetunion, welche etliche Bereiche der Wissenschaft und Technologie anführte. Die UdSSR hatte soeben das Weltraumzeitalter eröffnet und die größte Bombe aller Zeiten zur Explosion gebracht. Meines Erachtens noch bedeutsamer war, dass dort viele der besten Mathematiker arbeiteten, u.a. Alexey Ivakhnenko und Valentin Lapa. 1965 veröffentlichten sie den ersten funktionierenden Lernalgorithmus für Netze beliebiger Tiefe, d.h. mit einer beliebigen Anzahl von Schichten. Wenn es einen »Vater des tiefen Lernens« in vorwärtsgerichteten Netzwerken gibt, dann ist es Ivakhnenko. Schon 1970 hatten manche seiner lernenden Netze acht Schichten, was auch nach 2000 noch als tief galt. Wie die heutigen tiefen NNs lernten sie, hierarchische, verteilte, interne Darstellungen eingehender Daten zu finden.

Marvin Minskys & Seymour Paperts berühmtes Buch Perceptrons (1969) über die Grenzen flacher NN behandelte also ein »Problem«, das bereits seit vier Jahren gelöst war :-) Das hätten sie eigentlich wissen müssen. Einige behaupten, dass dieses Buch die NN-Forschung zerstört habe, aber das ist natürlich nicht wahr, zumindest nicht außerhalb der Vereinigten Staaten. Vor allem in Osteuropa bauten in den folgenden Jahrzehnten viele Forscher auf Ivakhnenkos Arbeiten auf. Noch in den 2000ern benutzte man seine viel zitierte Methode zum Trainieren tiefer Netze.

Heutzutage verlassen sich die meisten kommerziellen tiefen NN allerdings auf ein gradientenbasiertes Verfahren, das als Backpropagation oder Rückwärtsmodus der Automatischen Differenzierung bekannt wurde. Seine heutige elegante und effiziente Form wurde erstmals 1970 in einem Anrainerstaat der UdSSR publiziert, nämlich in Finnland, und zwar durch Seppo Linnainmaa in seiner Diplomarbeit (eine Verfeinerung von Kelleys 1960er Arbeit zur Steuerungstheorie). Linnainmaas Methode wurde in den Vereinigten Staaten erstmals 1982 von Paul Werbos auf NN angewendet. Sie dient heute dazu, bestimmte NN-Verbindungen schrittweise zu schwächen und andere zu stärken, sodass sich das NN mehr und mehr wie sein Lehrer verhält.

Eine besonders nützliche NN-Architektur namens Konvolutions-NN oder CNN (Convolutional Neural Network) wurde in den 1970er-Jahren von Kunihiko Fukushima in Japan entwickelt, wo NN mit Konvolution 1987 auch vom deutschen Forscher Alex Waibel mit Backpropagation kombiniert wurden. Der Franzose Yann LeCun trug in Amerika viel dazu bei, CNN zum Standard in der Bilderkennung zu machen.

Die DL-bezogenen Interviews des vorliegenden Buches mit LeCun, Bengio & Hinton erwähnen allerdings weder Linnainmaa, den Backpropagation-Erfinder, noch Werbos, den ersten, der das Verfahren auf NN anwendete, noch Fukushima, der 1979 die grundlegende CNN-Architektur veröffentlichte, die sie häufig nutzen. Sie zitieren auch nicht Ivakhnenko & Lapa, die Begründer des DL. Ich begrüße daher die Gelegenheit, in diesem Vorwort diese Urheber der grundlegenden DL-Konzepte zu würdigen.

Die leistungsfähigsten NNs von heute sind in der Regel sehr tief und vielschichtig, mit zahlreichen aufeinander folgenden Rechenstufen (je mehr derartige Stufen, desto tiefer das Lernen). In den 1980er-Jahren funktionierte das gradientenbasierte Training jedoch nicht für tiefe NN, sondern nur für flache.

Dieses DL-Problem offenbarte sich vor allem bei rekurrenten bzw....

| Erscheint lt. Verlag | 22.10.2019 |

|---|---|

| Reihe/Serie | mitp Professional | mitp Sachbuch |

| Verlagsort | Frechen |

| Sprache | deutsch |

| Themenwelt | Mathematik / Informatik ► Informatik |

| Schlagworte | Data Science • Deep learning • KI • Künstliche Intelligenz • machine learning |

| ISBN-10 | 3-7475-0011-0 / 3747500110 |

| ISBN-13 | 978-3-7475-0011-8 / 9783747500118 |

| Haben Sie eine Frage zum Produkt? |

Größe: 1,6 MB

Digital Rights Management: ohne DRM

Dieses eBook enthält kein DRM oder Kopierschutz. Eine Weitergabe an Dritte ist jedoch rechtlich nicht zulässig, weil Sie beim Kauf nur die Rechte an der persönlichen Nutzung erwerben.

Dateiformat: EPUB (Electronic Publication)

EPUB ist ein offener Standard für eBooks und eignet sich besonders zur Darstellung von Belletristik und Sachbüchern. Der Fließtext wird dynamisch an die Display- und Schriftgröße angepasst. Auch für mobile Lesegeräte ist EPUB daher gut geeignet.

Systemvoraussetzungen:

PC/Mac: Mit einem PC oder Mac können Sie dieses eBook lesen. Sie benötigen dafür die kostenlose Software Adobe Digital Editions.

eReader: Dieses eBook kann mit (fast) allen eBook-Readern gelesen werden. Mit dem amazon-Kindle ist es aber nicht kompatibel.

Smartphone/Tablet: Egal ob Apple oder Android, dieses eBook können Sie lesen. Sie benötigen dafür eine kostenlose App.

Geräteliste und zusätzliche Hinweise

Buying eBooks from abroad

For tax law reasons we can sell eBooks just within Germany and Switzerland. Regrettably we cannot fulfill eBook-orders from other countries.

aus dem Bereich